奇点灵智胡琛:做AI硬件,为什么我们要“软硬倒置”?|OpenTalk

来源|多知

整理|徐晶晶

近日,在多知OpenTalk第52期现场,奇点灵智联合创始人胡琛以即将推出的多奇AI小外教为例,分享了硬件创业的一套方法论——“软硬倒置”。

奇点灵智成立于2023年7月,其核心团队为创始人兼技术负责人包塔、联合创始人徐毅斐和胡琛。包塔曾和周枫等人联合创办网易有道,2017年加入美团,担任美团副总裁、美团金融CTO。徐毅斐曾担任字节跳动“大力智能台灯”的平台产品负责人。胡琛和包塔同为网易有道联合创始人,也是清华计算机系96级的连续创业者代表。

2025年8月,奇点灵智获得由星连资本领投的数千万元天使轮投资。

在3-8岁低幼儿童启蒙领域,奇点灵智将推出一款与众不同的家庭机器人——多奇AI小外教。它从英语启蒙切入,凭借多模态大模型、实体交互和主动拟人化陪伴,倡导“让孩子回归最自然的实体空间进行学习”。

然而,这条创新之路并非坦途。胡琛坦言,多奇的诞生得益于一套独特的硬件研发方法论:通过“软硬倒置”先行验证交互,借“多目标解耦”控制风险,并持续通过“双端用户研究”与“用户共创”倾听真实用户声音,最终精准抵达市场需求。

胡琛的核心观点如下:

1.硬件形态对低幼儿童提供了独特的情感连接,单一语音通道的多轮互动方式难于让小朋友持续输出。

2.当设备既能“听见”又能“看见”时,它才真正进入了孩子的生活世界,实体玩具的交互方式让孩子更自然上手。

3.我们最终将第一代产品的核心价值定位在英语启蒙上——这也是AI能力最能被中国家长感知和认可的切入点。

4.敬畏硬件产品的行业规律,也要发挥灵活的软件迭代思维。 用“模拟软件+模拟硬件”验证技术可行性,再通过“用户共创”验证产品价值。

5.创业是长跑,不是跟风跑。

以下为胡琛的演讲(经多知编辑):

大家好,我是来自奇点灵智的胡琛。

我和两位创始人在互联网行业都从业了近20 年。从一起参与创办有道开始,我们完整经历了搜索时代的变革,也赶上了移动互联网的爆发期。到了 2023 年,面对这一代 AI 带来的革命性变化,决定再次创业。

过去我们一直做教育、互联网和软件,但这次,我们直接扎进了低幼儿童的硬件赛道。今天我不展开讲产品细节,而是重点分享我们过去两年在创业路上踩过的坑、总结的方法论和收获,希望能对正在做AI硬件的小伙伴或者想要做这个方向的朋友有所帮助。

01 锚定大方向:找内容+硬件+AI的结合点

我们为什么会选择 3-8 岁的低幼市场?我们发现,孩子一到三年级,家长就开始为学习焦虑。但在 3-8 岁这个阶段,大多数父母仍然希望孩子快乐启蒙、在生活中学习——这个需求目前还存在很大的市场空白。

过去,这个年龄段的产品非常分散,比如点读笔、故事机、思维机、绘本阅读机等等。为什么没有一个像“学习机”那样专属、主流的设备?再看年龄大一点的孩子,小学生有小天才手表,中学生甚至可以用上手机。只有低龄儿童,始终没有一台真正属于他们的主机设备,需求被各类产品切得非常分散。

我们分析,其中一个核心原因是低龄孩子的注意力非常分散,很难长时间专注,也就难于做到持续的兴趣驱动。

那我们就在想:能不能借助这一代 AI 的能力,用更个性化的方式,像家里来了一个小伙伴那样,让孩子愿意主动去互动、去建立联系?这就是我们创业最初、也最朴素的想法。

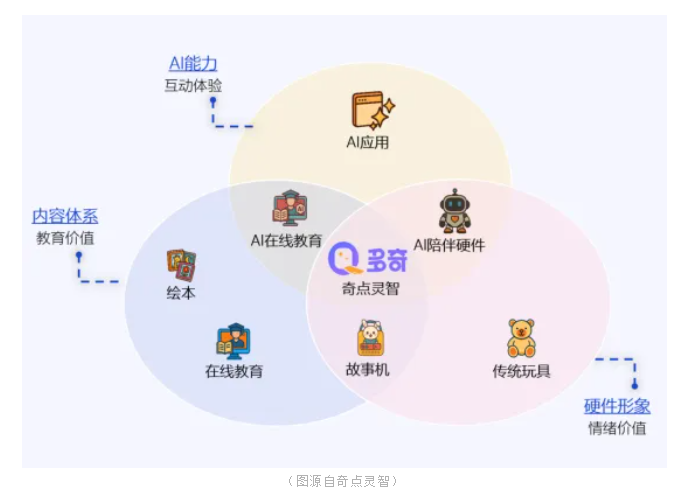

我们按内容体系、AI能力和硬件形态这三个维度,对市场上的儿童产品做了分类。左下角是传统的教育产品,它们更侧重教学体系。这类产品结合AI后,通常以软件应用的形式出现。但对于低龄孩子来说,右边这个圈也至关重要——他们需要一个能与伙伴建立情感连接的触点,而传统玩具正具有这种不可替代的情绪价值。

于是我们想:如果把AI能力和教育体系,一起放进硬件里,效果会不会更好?市场上已有一些“内容+硬件”的结合体,比如故事机,但它们大多缺乏优秀的AI能力。同时,家长对玩具的普遍期待又是“寓教于乐”。

所以,我们决定探索这三个圈交叉的区域,会带来什么。

02 来自Osmo+大力台灯的启示:做既能“听见”又能“看见”的产品

我想分享方法论的第一步是“设计冲刺”。这是软件行业里一套非常经典的如何从想法到落地的方法论,指在没有任何实体产品之前,通过团队脑暴把混乱的想法梳理成可行方案,再通过快速验证来确认整个流程是否可行。

两年前九月,公司刚成立时,我们有一个特别朴素的想法:做一个会说话的毛绒玩具。我们想,如果能用AI大模型让玩具开口说话,应该会很有趣。就这么一个简单的念头,我们决定先试试看。

怎么验证这个想法靠不靠谱呢?直接做用户调研?问小朋友“你喜欢吗?”——他们肯定会说“喜欢”,但这种反馈其实没什么参考价值。

我们的验证方法很直接:直接把蓝牙音箱塞进玩具熊肚子里,工程师在隔壁用变声软件冒充AI。

测试一开始效果不错:五六岁的孩子深信这只熊“活”了,全神贯注地跟这只熊玩了整整40分钟。我们当时特别兴奋,觉得这个思路可行!但打脸来得很快,结束时小朋友说“很好玩”,但是坚决表示“下周不来了”。这个反差促使我们反思,热闹的互动背后可能存在着我们未曾察觉的问题。

回看两天内八个孩子的测试录像时,我们才发现问题所在:所有孩子都挺直了背,像在听课一样紧绷,完全不是放松听故事的状态。这种多轮语音互动要求他们不断思考、组织语言,就像在做“口头作文”,而“熊”的反应速度又总是快人一步,无形中给孩子带来了巨大压力。

我们发现,低龄孩子的抽象思维和生活经验都有限,当要求他们长时间进行大段对话时,压力其实很大——就像成人参加即兴演讲,过程刺激,但极度消耗精力。我们担心,这种单一语音通道的互动方式很容易让孩子疲劳。

我们当时就有一个预判,这样的产品很可能“买回家第一周新鲜,第二周吃灰”。第二个预判是,大模型本身在快速迭代。两年前的语音交互能力还很初级,但现在像“豆包”这样的模型已经相当流畅。这反而催生了一个新挑战——如果市场上同时有五六家公司在做类似的语音玩具,两年后他们的产品会有什么区别?答案是:几乎没有区别。最近的玩具展上,整条通道十几家展商都在展示会说话的毛绒玩具,底层调用的都是相似的国内大模型。这意味着竞争最终又会回到硬件的蓝海:拼供应链和成本控制。或许头部一两家公司能靠融资拿下热门IP,通过品牌溢价获得利润反哺产品迭代,而大多数创业团队很难在这样的竞争中持续。

所以我们很庆幸通过这样模拟实验的方法,能及时发现单纯依赖语音交互的风险。

顺着这个思路继续推进,我们立刻把目光投向了多模态方向。除了语音通道,我们开始思考如何加入视觉交互能力。当设备既能“听见”又能“看见”时,它才真正进入了孩子的生活世界——互动方式变得更自然,体验也更丰富。

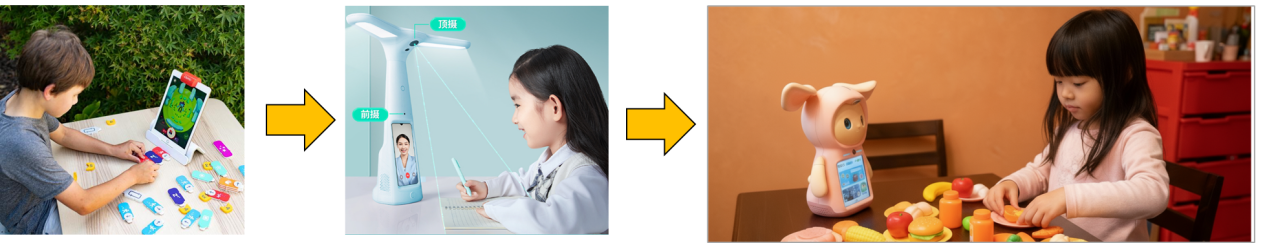

我们回想到在iPad兴起的时代,国外有一款叫“Osmo”的儿童益智电子产品,通过把类似潜望镜的小镜头,装在Pad平板上之后,通过光线反射,能把桌面上孩子玩的七巧板等实物反射进平板摄像头里。这样一来,平板里的虚拟世界就和现实中的玩具就产生了互动。

这种虚实结合的路径后来在字节的“大力台灯”上也有呼应——台灯头顶的摄像头能捕捉桌面上的作业或绘本,孩子用手指点不认识的字,台灯屏幕就会在“脖子”位置给出反馈。

这些产品给了我们很大启发:如果借助这一代AI技术所具备的更完整的多模态能力,我们能不能再往前走一步?比如,让孩子拿起家里的任何实物——他的玩具、日常物品——机器人都能“看见”,并能基于看到的东西主动发起对话。就像一位幼儿园老师,会主动蹲下来和孩子平等对话那样:“你今天的头发真好看,是妈妈给你买的发夹吗?”“这件裙子是什么颜色?你喜欢这个颜色吗?”

当机器人能主动“看见”并回应现实世界中的事物,互动场景就会大大丰富。孩子不会觉得它是一个冷冰冰的AI,而是一个能理解他生活的伙伴。这正是我们引入多模态能力的初衷——只有先“看见”,才能建立起真正陪伴型的伙伴关系。

基于这些思考,我们在产品定义时明确了一点:除了大模型的语言能力,必须把多模态视觉也融合进来。

03 多目标解耦验证:“抓住低龄儿童最本真的交互方式”

听起来,集齐摄像头、屏幕、喇叭和麦克风似乎已经足够“强大”。但孩子需要的是一台高配置的PC吗?他们会因为参数和性能而选择产品吗?并不会。

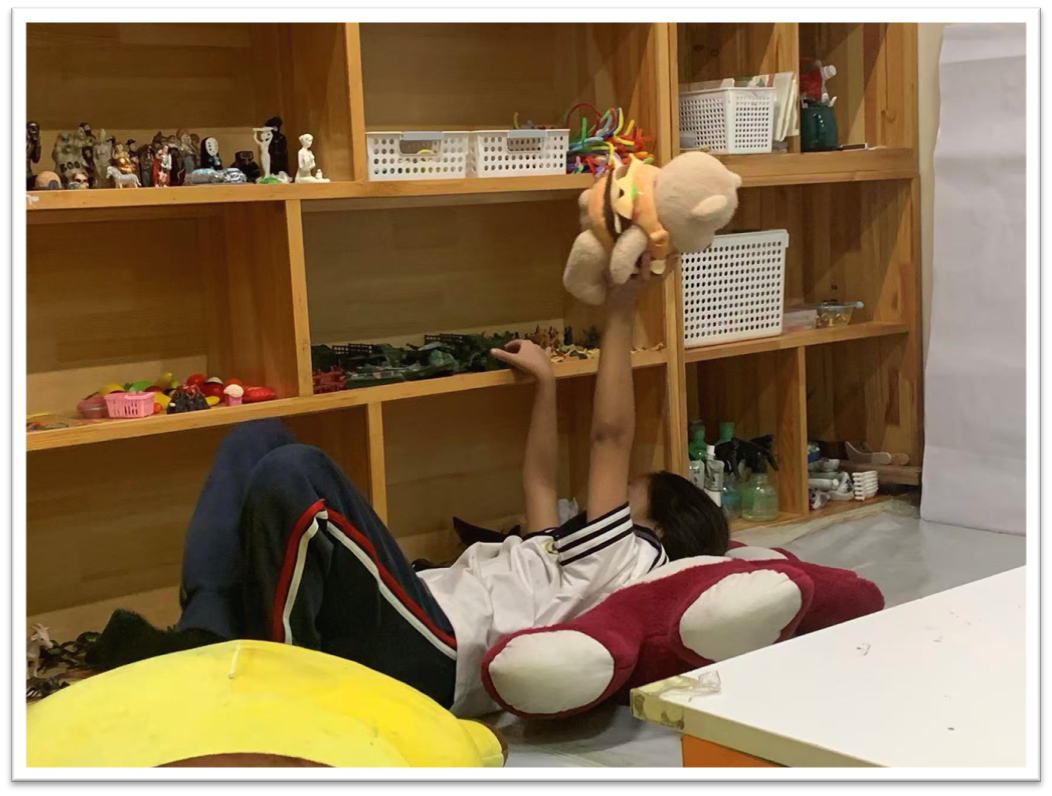

我们做了很多轮线下的调研,深入到真实的儿童活动场景中去寻找答案。在儿童活动站的沙盘游戏区——一个让孩子通过小玩偶表达情绪、自由扮演的空间——我们观察到孩子彻底放松时最自然的状态:他们或躺或趴,甚至随意打滚,完全沉浸在自己的世界里。孩子们最热爱的是“过家家”,他们用手里的玩偶和道具,用自己的语言构建出一个想象的世界。这是我们看到的低龄孩子最投入、最持久的沉浸状态——他们能长时间与自己的小玩偶对话、游戏,甚至把白天在幼儿园的经历、和小朋友之间的互动,都编进自己的剧情里,通过角色扮演和即兴配音,生动地演绎出来。

我们从中获得了一个重要启发:之前我们更多是从硬件技术出发做推导,而现在,我们决定回归到孩子最本质的交互方式上——不去改变他们的使用习惯。既然低龄孩子天生就喜欢“过家家”,那我们为什么不能用AI来陪他们过家家呢?通过这种方式,孩子能以最自然、最舒适的状态,用自己最熟悉的方式,继续做他们喜欢的事。

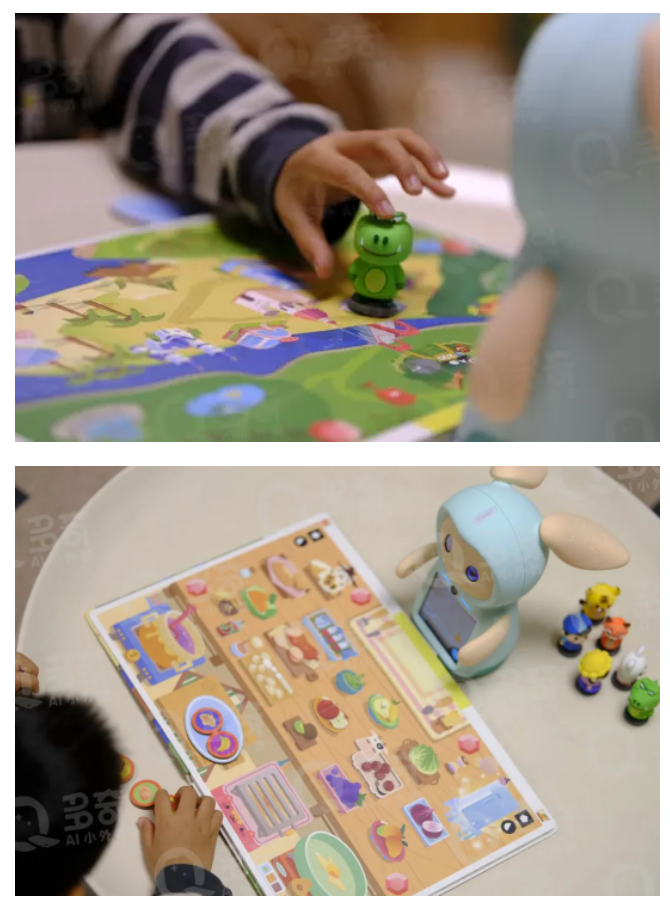

大家现在看到的,就是我们最终的产品形态:

我们设计出一种让AI“陪孩子过家家”的交互模式,比如让小朋友在“餐厅游戏”中用小道具做饭,AI在游戏化场景中引导开口说英文单词和短句。这种“孩子本能驱动”的交互方式,让学习变成了玩耍。

这就是我们产品在交互上的核心差异。市场上不少硬件产品也支持聊天或多模态识别,但对我们来说,最大的不同在于——我们抓住了低龄儿童最本真的交互方式。这种设计的好处是,孩子不需要学习,拿起来就会玩,因为这本来就是他们自己的游戏方式。

这个想法虽好,但验证又成了新难题。因为这次比刚才提到的“小熊+音箱”难度更大了,这次得带着摄像头验证,需要摄像头精准识别道具,并且还要有屏幕的实时反馈,难道要直接开模投产吗?做过硬件的都知道,一旦开模就是几十万上百万的投入,错了代价太大。

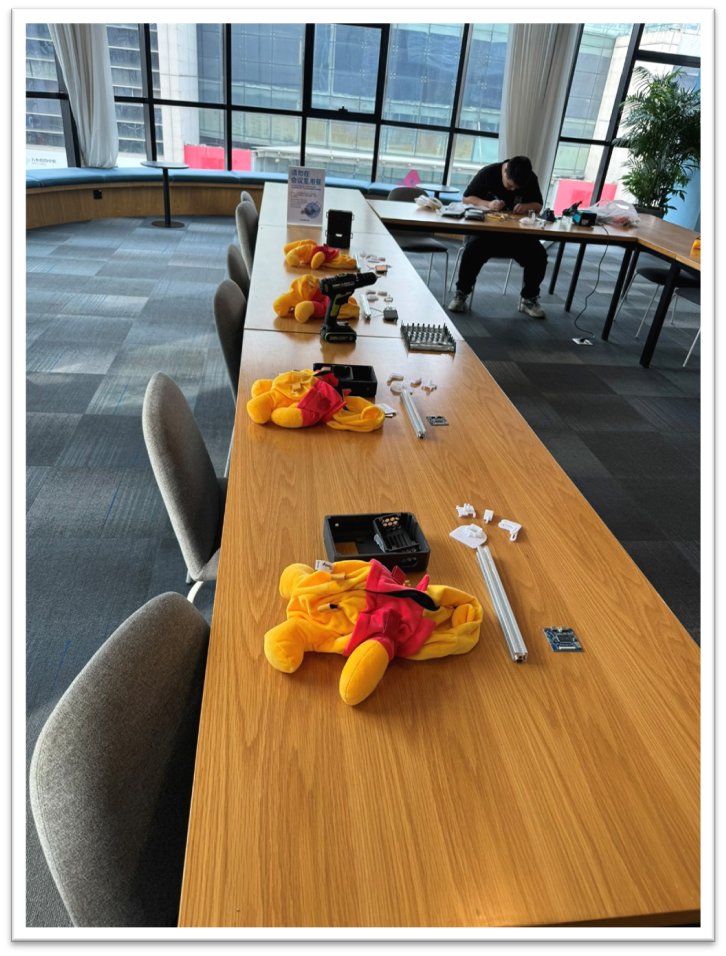

于是我们采用了“多目标解耦验证”的策略。硬件可靠性、交互体验、外观喜好——这三个目标如果等到量产才验证,失败成本太高。我们决定把它们拆开,分批验证。

我们想了个巧妙的办法:使用Mini PC(一种小饭盒大小的电脑),通过3D打印外壳做成“小书包”,缝在玩具小熊的背上,导线从腹部穿出,连接胸前的屏幕、眼睛的显示区和鼻子的摄像头——这样在正式开模前,就用标准PC硬件和软件代码提前模拟出连贯的产品交互功能。

这个方法让我们无需工厂介入,软件团队直接在PC端就能开发验证所有交互逻辑和视觉算法。直到所有软件验证通过后,第二年我们才启动工厂合作,把代码迁移到嵌入式平台。这不仅控制了硬件早期的投入成本和风险,也让我们能在最熟悉的开发环境中快速迭代。

我们将这套验证方法称之为“软硬倒置”。它的核心在于,在投入硬件生产之前,我们先用软件和原型设备,把所有交互玩法——无论是餐厅游戏、猜拳互动,还是真人体感玩法——全部提前验证一遍。

这样做最大的好处是,对小朋友来说,体验是完全真实的。他们面对的不是冷冰冰的测试设备,而就是一个会陪他们玩的玩具熊——这让我们能在最接近真实使用的环境中,获得最真实的反馈。

去年春节前,我们团队全员上手,手工缝制了一批玩具熊。我们把熊的内部掏空,逐个装进摄像头骨架和屏幕,最后为它们“背上”装着Mini PC的小书包。就这样,我们做出了第一批赶在除夕入户测试的“原型机中的原型机”。

这种方式带来了两个关键优势:

第一,这批设备在小朋友家里度过了完整的春节假期。孩子在完全自然放松的状态下使用,我们观察到的才是真实的用户留存情况和玩法偏好,而不是在实验室里“表演”出来的行为。

第二,这个办法让我们比正式开模提前了整整十个月拿到用户反馈。这意味着我们有充足的时间迭代软件、优化交互,彻底摆脱了“硬件做完才能调软件”的传统流程束缚。

04 以用户为中心,从双端用户研究到用户共创

除了软硬件流程上的重构调整,我们还做了一项关键工作:双端用户研究。我们的产品购买者是家长,使用者是孩子,因此必须同时理解两方的需求。

针对家长端,我们主要通过两种方式开展研究:第一种是实验室测试。我们会邀请孩子来体验产品,观察他们的使用行为和数据,并在结束后聊聊他的主观感受,注意语言表达和实际行为的差异和背后原因;第二种是家庭深访。我们会进入真实家庭环境,由专业研究员观察他们已有的儿童硬件产品、孩子的作业情况、每周辅导频率,以及孩子自主玩耍的时间。通过这些,我们深入理解家长对产品的期待和优先级:是语文、数学、百科,还是英语?

正如一位妈妈参加访谈时留下的金句:“数学爸爸可以教,古诗爷爷能背,只有英语,我和孩子爸爸可能也都不太行。”这个现实痛点,让我们最终将第一代产品的核心价值定位在英语启蒙上——这也是新一代AI能力最能被中国家长感知和认可的切入点。

除了观察和理解用户,我们会进一步邀请用户参与共创。例如,在公司品牌确定为“奇点灵智”后,“AI小外教”的名字“多奇”以及长什么样,都是来自孩子们和妈妈们的投票反馈。

去年夏天,我们一开始为“多奇”设计了两个IP外观形象:可爱的小熊猫和奇幻的小精灵。最开始尝试的小熊猫外观,在后续的世界观延展里受到天然的角色限制(比如小熊猫站在动物园外介绍动物们,就有点怪怪的);而小精灵的延展性更强,不同的小朋友都有自己的解读和创造,似兔似羊又不完全模仿单一动物。最终的外观是由妈妈和孩子共同投票选出的。这个过程中我们有个有趣的发现:妈妈和孩子审美偏好不同——低龄小朋友更喜欢“呆萌”的造型;而妈妈对机器人会有倾向于科技感的惯性认知,但最终都会尊重孩子的选择。我们就需要在外观上,去找到玩偶玩具的亲近感和科技感的平衡点。

再比如游戏玩法。我们最初的设计都是基于成年人的逻辑假设,但孩子根本不按常理出牌——他们会把道具混在一起,自创一套规则。有趣的是,这种由孩子自发创造的玩法,往往其他孩子也很喜欢。

这种从研究到共创的过程,让我们始终保持“以用户为中心”的产品逻辑——既理解他们,也与他们一起创造。

最后我想总结一下,我们这套“软硬倒置”的方法论所带来的根本性改变。

以前做纯软件时,我们的流程是“开发-上线-根据用户反馈快速迭代”。那时硬件(手机)是用户自备的,我们只需把软件上架即可。

但当我们自己做硬件时,一切都变了。硬件一旦投产,再想修改成本极高。因此,我们主张在传统流程之前,先加入两个关键循环:用“模拟软件+模拟硬件”验证技术可行性,再通过“用户共创”验证产品价值。这相当于在产品开模前,先把所有潜在问题提前暴露并解决。

05 “创业是长跑,不是跟风跑”

最后,我再分享一下做硬件创业以来的几个感悟:

1.敬畏硬件产品的行业规律,也要发挥灵活的软件迭代思维。

如何绕过硬件开模到量产的生死槛,想办法更早拿到用户洞察和假设验证的结果。这是我们此次创业的重要收获。

2.AGI时代团队的“小而美” 趋势——“经历过从0到1再到N的复合型人才”。

T型人才结构:在专业领域有足够深度,同时知识面广泛。

强单兵作战能力:能独立负责并打通完整业务模块。

无断层的能力矩阵:确保团队知识覆盖全面,没有“无人会做”的环节。

3.心态“归零”,下地插秧。

创业团队资源和精力有限,必须拒绝“既要又要”的诱惑。大厂高P必须主动“归零”,忘掉曾经的互联网黑话,生态位、护城河、平台思维……大厂加持的光环,不是个人能力。从最小的模型验证开始,亲自“下地插秧” 。

4.创业是长跑,不是跟风跑。

灵感可贵,但创业是一场将灵感转化为实际产品的马拉松。需要经历从概念验证、原型开发、到功能迭代的完整周期。每一步都做扎实,才能避免同质化的“me too”。真正的壁垒,在于你先投入足够的时间,把思考凝聚成你独有的产品。

06 Q&A:“AI无法替代专业教研老师的核心价值”

问:您好。我是一名四岁孩子的家长。多奇这款产品,如果面对的是更零基础的孩子,怎么保证效果?另外,多奇是否有以语言学习的教学目标为规划的一套体系?

胡琛:因为时间关系,我今天主要分享的是我们自己硬件创业的方法论,产品细节未能充分展开。 在我们的设计中,主要将孩子分为两种典型用户画像:

第一类是零基础型的孩子。针对他们,我们设计了一套游戏化的激励体系,引导他们从简单的单词和短语轻松入门,在趣味中建立对英语的好感。

第二类是已有初步学习经验的孩子。对于他们,产品侧重提供一种“浸润式”的英语氛围陪伴。这解决的正是家长的核心痛点——如何在课后、在家中延续孩子的语言环境,让学习不止于课堂。

对应这两种需求,我们设置了不同的产品机制:

对于零基础孩子,产品会像一位耐心的启蒙老师,通过精心设计的爬坡路径,帮助他们稳步建立信心。

对于有基础的孩子,多奇则能化身为一个对话伙伴,借助多模态交互和底层语音聊天能力,与他们进行更开放、自然的互动。

您的第二个问题是关于体系。请放心,多奇在后台有完整的教学体系作为支撑。

我们运用AI进行能力分级、内容调配和个性化推送,这一切都与中国家长认可的教育理念紧密对齐。毕竟,如果不能建立起扎实的教育体系,产品很容易被视作短期玩具。

正如之前提到的,虽然我们从英语切入,但目标是成为低龄儿童的一台“学习主机”。这意味着我们必须构建能够持续交付价值的系统框架。因此,您说的“体系化”我完全认同——这确实是我们和在场各位专家的共识。

问:您好。AI对于多奇的内容搭建来说,起到了哪些作用?

胡琛:正如前面几位专家老师分享的,AI在产品和体验中扮演着双重角色。

在用户体验侧,我们通过AI对话和内容生成,为孩子提供即时、生动的正反馈。例如,当孩子讲故事时,屏幕上的虚拟场景会随着情节动态变化,把这个故事呈现得非常有趣。

在后台系统侧,AI则承担着个性化引擎的角色。我们通过分析每日对话,为每个孩子构建“知识图谱”和“兴趣图谱”。比如,如果孩子提到喜欢恐龙,那么后续的学习环节或者说我们设计的互动游戏中,AI角色就会自然引入相关话题,让孩子感到被理解和共情,从而更投入。

不过,我们也非常认同前面几位嘉宾老师的观点:AI无法替代专业教研老师的核心价值。实际上,我们的教研老师会先搭建严谨的教学框架和内容模板,AI则在这个规则体系内发挥其生成多样性内容的优势。

简单来说,教学的核心规则由人设定,而自由聊天等开放性环节则由AI充分发挥其生动和个性化的 特点。同时,这些互动中产生的数据又会反哺我们的知识图谱,形成“越用越懂你”的良性循环。

相关阅读:

潮起时:互联网大咖闯入儿童赛道,做了款不一样的AI伴学机器人

OpenTalk第52期回顾: